在功能层上进行合理布局、给予用户完善的交互体验,是几乎所有产品都需要遵循的一个原则,智能座舱产品也不例外。那么智能座舱的语音交互功能,包括哪些组成环节?本篇文章里,作者针对智能座舱的语音交互设计及发展做了解读,一起来看。

之前有车企的负责人咨询当前智能座舱语音交互的现状和发展趋势,笔者借此做个简单的总结和归纳,以下内容将分为语音交互的唤醒、聆听、理解、播报4个部分。

一、唤醒

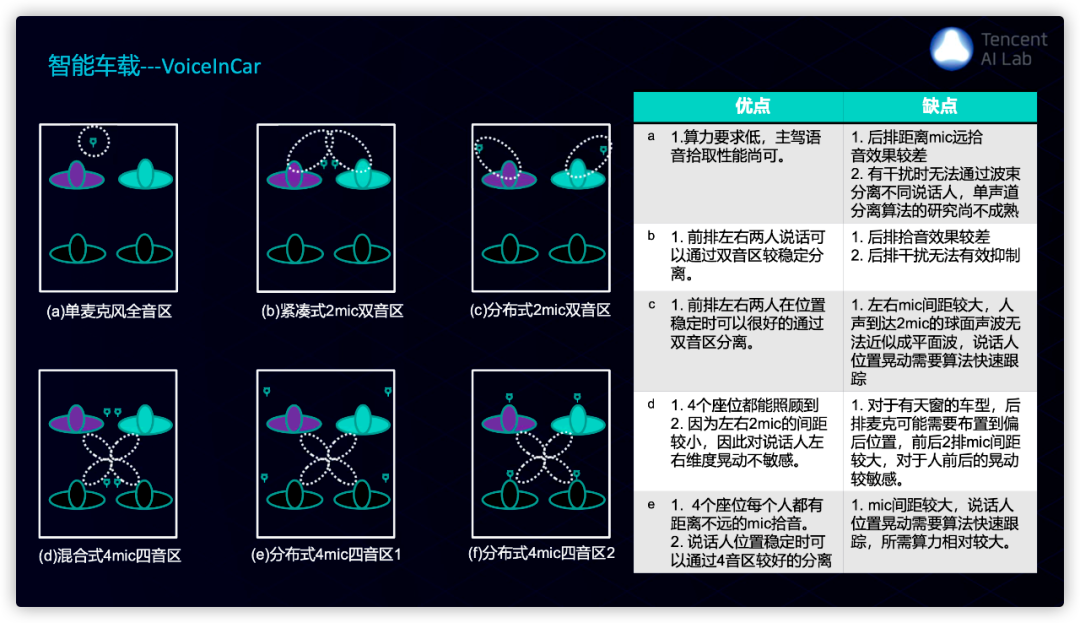

1. 声源定位从双音区发展到四音区

使用声源定位的目的主要有两个,第一个目的是知道是谁在说话并提供个性化服务,例如副驾说“打开窗户”,这时只有副驾的窗户会被打开;第二个目的是实现定向拾音,由于车内外环境的噪音较大,同时乘客之间的讨论和回声会影响语音交互的拾音质量,因此声源定位能让麦克风阵列锁住某个方向的声音。

双音区的意思是将座舱分为左侧和右侧,无法识别是驾驶员还是后排左侧的乘客说话,因此局限性较大。四音区可以将座舱区分为驾驶员、副驾、后排左侧和后排右侧四个区域,能较好地解决双音区的问题。

以下是腾讯腾讯AI Lab总结的各种车载麦克风阵列分布形式,及其优缺点 。

2. 语音交互支持One-Shot

部分语音技术供应商支持“One-Shot”技术,这也被称为“唤醒连说”。它的意思是“唤醒词+意图识别”一体化,支持用户可以在说出唤醒词之后不作停顿,立刻说出后续需求。

例如用户直接说“Alexa帮我打开车窗”,Alexa就能直接把车窗打开。这种方式摒弃传统的一问一答的形式,极大减少用户语音操控的步骤,化繁为简,操作简便。“One-Shot”不会改变语音交互设计的任何逻辑,但它能明显提升使用时的体验。

3. 语音交互支持唤醒词+离线意图识别

离线识别就是为了解决信号不好导致指令无法执行的问题。为了控制硬件成本和体积大小,客户端的算力远不如云端,其次核心算法放在本地有被竞争对手盗取机密的可能,所以我们不可能将所有的识别技术放在本地进行。

一般离线识别主要服务于常用简单的指令,例如“打开车窗”、“调节温度”等等,它们会通过正则表达式获取关键词,匹配指令后执行。

4. 语音交互支持免唤醒指令

部分语音技术供应商支持“免唤醒”技术,例如省略“Alexa”直接说“打开车窗”,车窗会直接打开。

其实“免唤醒”正是用了唤醒词技术,只不过把默认唤醒词改为指令,新的唤醒词被命中后会直接执行相关指令。

但是,我们不能把所有的指令设置为免唤醒,首先唤醒词识别有自己的局限性,不是所有的文字都能被正确识别,其次,越多的唤醒词意味着被误唤醒的几率越高。用户对其他乘客说打开车窗时,语音系统会误以为用户对自己发出的指令从而执行了相关操作。所以“免唤醒”要慎用。

5. 语音交互支持多模唤醒

语音交互唤醒方式除了常见的唤醒词和方向盘按键,姿态追踪和眼动追踪在未来有可能成为语音交互唤醒的新方式。

在人和人的交流过程中,当A转向并看着B时,B大概率知道A要发起交流,而且A也不会先说:“你好,B”,除非两者关系较差或者场景比较微妙。

在人机交流过程中应该满足以上场景,如果智能座舱中拥有一个实体机器人或者在屏幕里有较大面积能显示一个语音助手,我们可以通过用户头部姿态的转向和注视时长判断用户是否想和语音助手发起交流,用户也有可能向语音助手挥手,以上动作触发后语音助手应该激活并开始聆听。

有读者可能会问,为什么要做这么多方式来唤醒语音助手?

因为自然交互和多模交互有个特点就是要考虑冗余的设计,用户在不同场景下有可能采用不同的方式向语音助手发起交互,例如在上车场景时用户心情较好确实有可能向语音助手挥手Say Hi,如果语音助手没有任何动静,用户的心情有可能受到打击;还有另外一个例子是小孩的交流方式是多样的,语音助手应该有相应的配合。

眼动追踪在未来有可能成为一种唤醒方式,当用户看向哪个地方并发起语音交互时,这时用户眼睛看向的地方会成为语音指令中的主语,例如仪表盘上突然出现一个红色图标,用户有可能看着它直接问这是什么意思?这时语音助手可以做相应的解答。

二、聆听

1. 全双工语音交互成为主流

持续监听可以理解为一旦唤醒语音助手,语音助手会把麦克风一直打开。用户可以一直说,语音助手会针对用户每一句话分别作出响应。

但是持续监听的体验依然存在很多问题,因为麦克风一直打开,语音助手会把所有的声音进行聆听并做出响应。假设上一轮对话未结束,这时候语音助手听到其他人说的话,误以为这是新的语音任务,会把上一轮对话直接结束并播报新的内容。

还有些具备持续监听能力的语音助手一旦听到其他声音会立刻停止播报,这对用户来说无疑是一种断断续续的体验,效果可能比单轮交互、多轮交互还要差。

目前很多车厂已经宣称自己的车配备了全双工语音交互技术,相比简单地把麦克风打开,全双工语音交互不会像持续监听一样容易被噪音打断整个对话过程。要实现以上效果,全双工语音交互需要拥有更强的抗噪能力和上下文理解能力,它能理解每一句噪音是否跟当前任务有关,并且能猜测当前任务下一轮对话是什么,这对于技术的要求非常高。

全双工语音交互可以简单地理解为真正的“边听边说”,用户一旦习惯了全双工语音交互,就很难回到以上单轮交互、多轮交互和持续监听三种交互模式,因为它们都不是自然的交互方式。

2. ASR支持自动校正

笔者发现以前自己在手机地图使用语音输入,它会根据你的口音、地理位置和历史记录等因素进行ASR的校正,以及将ASR中出现一些同音字、二义性词以及用户发音不标准或者说错的字词进行校正。

百度地图、高德地图的手机地图做得好的原因是地图是用了自己的语音交互系统,以及十多年的地图数据积累,但是车载地图的语音交互系统有可能采用的是思必驰、科大讯飞等供应商,在ASR校正时缺乏地图数据的校验导致识别准确率较低,这个问题的解决需要多个供应商一起配合才能较好地解决。

3. 声纹识别在未来有一定作用

声纹识别在聆听过程中能有效区分不同人正在说的话,对于上下文理解有一定的帮助,而且根据应用场景为车内驾乘人员提供差别化服务,但目前有可能因为技术仍未成熟暂未看到有车企使用了声纹识别技术,在未来有一定的发展空间。

三、理解

1. 支持一句话包含多个任务的理解

这是一项体现语音交互高效率的重要特性。一般来说GUI完成一项任务需要分几个步骤,语音交互可以一句话就搞定,在导航场景下用户可以说“我想去广州机场,途中先去趟超市和充电站”,语音交互可以帮助用户一次性设置三项途经点,效率提升了不少。手机百度地图在几年前已率先支持该能力。

2. Shortcuts成为基础能力

iOS应用Shortcuts允许用户设置多个指令,然后命名为一条语音指令,用户只要对Siri说出这条语音指令就能把相关指令按顺序执行。小鹏汽车在2020年已经支持了Shortcuts功能。

3. VUI和GUI融合将成为系统底层设计

小鹏汽车在2020年发布的全场景语音交互正是将语音交互和GUI进行深度打通,它能有效实现语音交互直接控制GUI上的控件和组件,极大提升了驾驶员对于系统控制的效率。

四、播报

1. 让播报音色更拟人

当前大部分语音助手在播报时语气没有任何变化,而且音色机械感强,实现语音助手的拟人化播报将有效提升语音助手的情感表达。小鹏汽车在2021年7月份新推出的小P版本声称具备愉快、温和、亲热等14种强烈情绪的变换能力,而且在微软MOS(Mean Opinion Score)语音质量评测中获得了4.49的高分(满分为5分,分数越高越接近真实人声)。

音色自定义也是一个可见得着的趋势,2019年百度地图推出了地图语音定制产品,用户只需在百度地图App上录制20句话,20分钟左右即可生成个人完整语音包,21年亿咖通携手百度Apollo定制新一代智能座舱系统也包含了相关功能。

2. TTS个性化播报

除了音色可以提升情感表达,根据场景定制TTS文本也能有效提升语音助手的情感表达。

举个例子,语音助手和所有用户对话过程中都会用“你”字,“不好意思我听不懂你能再说一遍吗”、“请问有什么可以帮你的呢”……如果将“你”字改为名字和昵称,这时表达和用户的感受会发生新的变化,因为用户知道语音助手知道自己是谁,这有可能会加强用户对语音助手的信任感;第二说名字和昵称更能体现亲切感,就跟朋友聊天的时候不会天天用“你”字。

再举个例子,当用户上车时语音助手会根据不同的上车顺序和用户身份一一打招呼,例如“Hi,奶奶(年老的妇女,坐在后排左侧)、小明(驾驶员)、小红(小孩,坐在后排右侧)”,这比语音助手只跟驾驶员打招呼亲切得多,而且能体现出这个语音助手是智能且懂礼貌的。

以上例子看起来是在TTS文案上进行优化,背后其实采用了一系列空间信息、身份理解以及性别、年龄预测等技术。以上技术都已成熟,虽然这看起来使用了大量技术而且最后呈现的结果仅仅是文案的变化,但笔者认为它们对于语音助手的情感化和个性化有质的提升。

最后,除了语音交互,基于声音的创新也在不断发展当中。由于驾驶员在驾驶过程很难看到背后的事物,但听觉能接收并感知来自360°的信息,因此在不同位置播放音效能有效对驾驶员进行预警和提示,提升驾驶员的空间感知能力。

除了空间上的预警提醒,娱乐和体验也是智能座舱重点关注对象,7.1声道以及7.1.4声道音响能为乘客带来不一样的感官体验,因为声音可以在空间中流动起来,这时电动汽车可以在7.1声道的基础上重新设计引擎声浪系统,也可以配合主动式氛围灯做更多空间上的渲染。